Inside專題報導 自駕新創歐特明,用 AIoT 之力攻入小鵬、鴻海 MIH

自動駕駛不只是 AI 與 IoT 相互結合一個非常重要的領域,也是一項離我們越來越近的科技;在台灣就有那麼一間坐落竹科的本土自駕車新創——歐特明(oToBrite)電子。

隨著各種設備與演算法不斷進步,自動駕駛不只是 AI 與 IoT 相互結合一個非常重要的領域,也是一項離我們越來越近的科技;而提到這個科技, 很多人第一直覺會想到特斯拉的純電腦視覺、GPU 大廠 NVIDIA 的 DRIVE 平台,或是隸屬 Google 的 Waymo;但在台灣也有那麼一間坐落竹科的本土自駕車新創——歐特明(oToBrite)電子。

歐特明在 2013 年由來自華晶科的吳錫慶所創立,其車用影像、駕駛輔助系統(ADAS)備受中國電動車新創小鵬青睞,不只成為小鵬 G3 跟 P7 自動停車系統的供應商,最近還加入了鴻海 MIH 聯盟,並有啟動 IPO 的打算。INSIDE 很好奇,這間台灣新創到底是怎麼發展他們軟硬整合能力的?為此我們採訪到擁有技術背景的歐特明商務開發經理曾怡舜,來跟我們談談他們發展 AIoT 能力的經驗。

怎從環景走到自動駕駛?

其實歐特明的業務範圍一開始還沒有到 AI,他們是以環景、透視底盤等車用影像系統起家的公司。但在 2015 時,小鵬以及本土車廠納智捷不約而同地找上門來,針對歐特明的技術想展開合作。

不過這兩間車廠對歐特明的期待不太一樣,納智捷是希望透過許多不同位置的攝影機,各自打造像移動物體偵測、開門警示、盲區偵測,以及前車離去提醒等安全警示系統,用上的攝影機除了環景攝影機之外,還包含了側方、前方的攝影機。

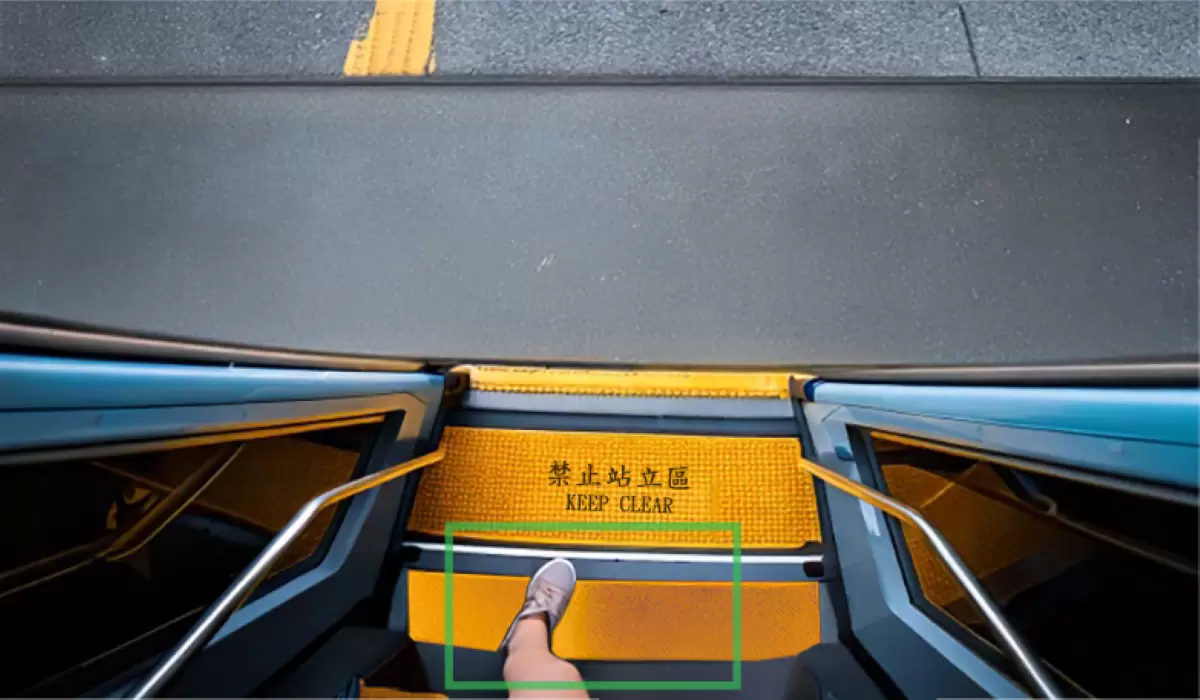

但小鵬就不太一樣了,他們想要以環景系統的攝影機為基礎,來打造自動停車(APA)的辨識功能,這也是讓歐特明一腳踏入電腦視覺的契機。曾怡舜說,當時自動停車主流都還是用超聲波雷達來辨識,但超聲波雷達只能看距離以及簡單地判別障礙物,實際上車是不是開進停車位,還是要由駕駛人為判斷;但視覺技術最大差異就是透過訓練後,車子可以看懂物體種類,看懂這是三角錐還是擋版。

小鵬的提案就此成了踏入 AI 影像技術的契機。一開始歐特明還沒使用 AI,而是用傳統以特徵規則為主的電腦視覺演算法發展視覺辨識的技術,但偵測效果一直有限,直到 2017 年開始將演算法導入深度學習,順利透過 AI 技術大幅提升系統正確率和誤報率,讓他們得以在隔年完成以深度學習為基底的開門警示(ODA)、盲區偵測(BSD),以及後來的自動停車、前方障礙物辨識(FCW)、車道偏移警示(LDW)等多項的視覺 AI 辨識、主動安全系統技術。

重點能力在「整合」

我們很好奇,在做自動駕駛的企業、新創很多,技術 roadmap 也很多,有做純視覺運算的,也有用不同感應器、光達、毫米波等各種組合,那歐特明自家到底有什麼獨特能力,跟其他系統廠一較長短呢?曾怡舜解釋,目前在做純視覺、只使用攝影機的代表當屬特斯拉,而包括歐特明在內其他公司、車廠都算攝影機搭配多重感測器這條路線;但是無論哪個派流,視覺運算系統終究都會在其中扮演相當重要的角色。

如果要把一套視覺辨識分拆的話,可以分成攝影機、邊緣運算系統(ECU)、AI 模型,以及資料四大部分。曾怡舜介紹歐特明特別之處就在於能用一條龍的方式,把這四個軟硬體要素通通自己一手包辦並加以整合在一起。

這些要素包括車規攝影機能自行生產、自行設計 ECU、自己寫 AI 辨識、AI 自動標記以及 AI 模型壓縮技術。「在跟小鵬的合作中,就連要拿來訓練 AI,那些停車格有黃色、粉紅色,線有並行、雙線、單線,樣式千變萬化的中國停車場實體影像,也都是我們自己去實地拍、去收集的!」曾怡舜笑著說。

那通通一手包辦,自己做軟硬整合的好處到底是什麼?拿最核心的攝影機舉例,車用攝影機必須在各種不同環境下都能穩定輸出高品質的影像,不能因為天候、路面或區域的差異就影響影像的品質;但這時對於鏡頭組裝的精密度、光學和機構的設計,以及影像調校的技術及演算法,甚至最後應該如何裝設在車上,都必要花很多力氣去滿足情境。

「每個情境都需要挑選適合的感應器與鏡頭,」曾怡舜說,甚至還要挑對的 ECU、對的 SoC,確定算法所需的算力、記憶體、通訊狀況,並在這 SoC 的架構下開發嵌入式系統。最後,甚至還要把在 PC 端開發的 AI 模型及演算法,一邊想辦法大幅度壓縮,一邊又要維持足夠的辨識率,「AI 模型自己做的訣竅就在這:很多人會想,不是拿市面上的開源模型來用比較快嗎?但這些模型在壓進 SoC 時通常都太大了!要壓就得修剪神經網絡,但剪太多辨識率又低,所以我們乾脆都自己寫。」這麼多複雜且精細的工作,通通都自己來往往才能在最短時間內全盤掌握。

未來在鴻海 MIH 扮演的角色

曾怡舜介紹,歐特明現在的商業模式還可以細分成兩種類型,第一類就是整套輸出自動駕駛辨識系統,這類的客戶會希望整套視覺 AI 辨識系統都由歐特明提供,所以輸出的整套攝影機、ECU 和 AI 算法,其鏡頭配置位置、SoC 的選型到最終 AI 算法都是一套固定的 Total Solution,這部分就會盡量降低客製化需求,但也能用最快的方式讓客戶的車輛裝上整套系統。

另一個部分就是把攝影機、ECU、AI 模型等三部分模組化分開輸出了,這類客群通常已經具備一定軟硬整合的開發水準,所以他們會希望能單獨挑選自動駕駛所需的攝影機、ECU、AI 模型。曾怡舜解釋,這兩種商業模式各自在營運上的差異就是變現週期,前者通常金額大但變現週期會拉的長一點,後者的變現週期會比較短一點但比較靈活。

不過不管是哪一種商業模式,還是會以原本最擅長的視覺 AI 辨識系統,來為鴻海 MIH 提供技術能力,並瞄準 Level 2+ 等級的自駕辨識市場,透過更深度的軟硬整合做到讓車輛可以輕鬆辨識各式物體、車道線、交通號誌以及可行駛區域;未來的中期目標則會把原本自動停車的辨識能力擴增至 Level 4 等級,讓自動停車升級到「記憶式無人代客泊車」,駕駛人只要在門口下車,車就會自己找好停車位、自己停好的境界。

來源: Inside AIOT 專題報導 https://www.inside.com.tw/article/24479-otobrite